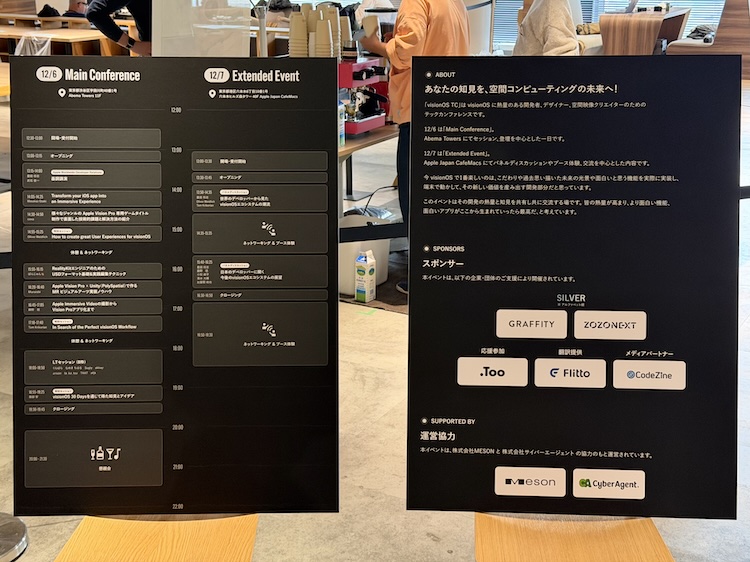

昨日感想を投稿した visionOS TC 2025 の、手元でガーっとメモしたものを備忘録がてら整理してみた。聴くのに集中してメモしていないものもあり。アーカイブ動画配信いただけるようなので楽しみ。

イベントページ:https://visionos-tc.com

Transform your iOS app into an Immersive Experience

- iOSの既存アプリをどうイマーシブに落とし込んでいくか?

- visionOS 開発では既存コードベースをほぼそのまま利用できる、せっかくvisionOS に対応するならイマーシブな体験を追加しよう

- イマーシブとは?

- Part of the content

- Makes you want to reach out instinctively

- Seamless transition

- Experience that moves you

- 東京「舞浜」

- 流動的な体験フロー:京王線のドアが開いて、アトラクションに向かうまでの体験

- どのように iOS アプリをいまー支部な体験に落とし込むか

- iOSの複雑な画面遷移の構造を乗り越える:シーンの概念を使う

- コアな機能だけを持って行って、そこから広げていくことも可能

- Step 1:iPhoneのスクリーンを7台並べる(マルチウインドウ)

- 横に並べるだけではなく、扇形に。眼精疲労を防止

- Step 2:iPhone のかたちにとらわれないものを並べる(紙面をグリッド状に並べる)

- iOS で使っている技術、SwiftUI の modifier だけで実現できる、RealityKit 使わなくて良い

- Step 3:(震源地図)

- Step 4:Metal を使ったビジュアライゼーション(衛星のリアルタイムレンダリング)

- イマーシブっぽく見せる工夫、ウィンドウを斜めに表示する

- iOSの複雑な画面遷移の構造を乗り越える:シーンの概念を使う

- ウィンドウの工夫、手を上げて操作する(ゴリラ腕問題)を解消するために、自動スクロールさせる

- コンテンツの文字部分と大きな背景画像は分離、いっぱい動かすと画面酔いを引き起こすため